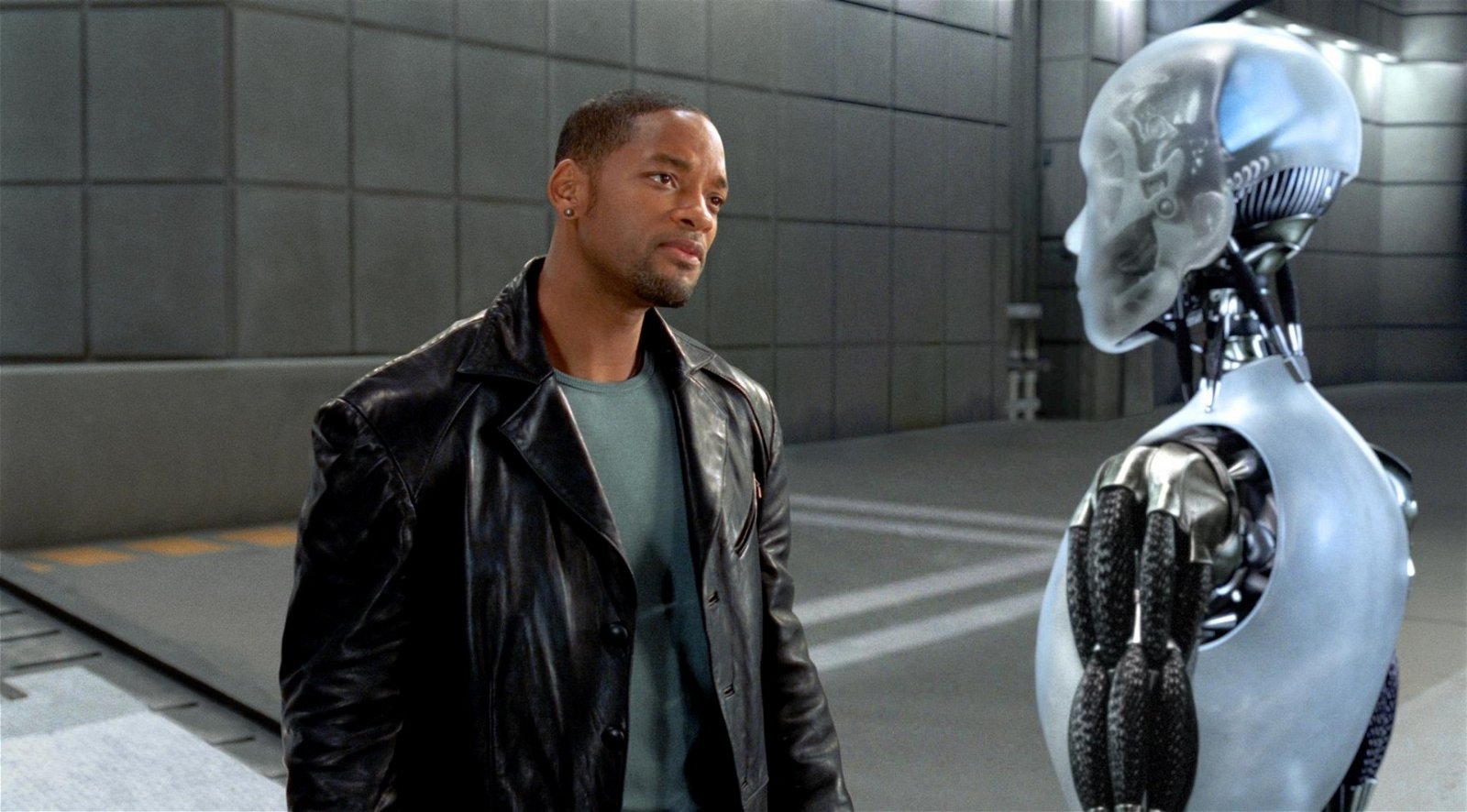

Los poetas, los guionistas y los novelistas comienzan a adentrarse en el terreno de los ingenieros. La tecnología, para hacerse humana, los necesita. Nadie miente como ellos y, ahora, distintas firmas de Silicon Valley que se dedican a desarrollar sistemas de inteligencia artificial quieren que sus robots de asistencia sean percibidos como algo vivo, con una personalidad y con una historia propia.

Sólo en 2015 las start-ups que se dedican a la asistencia virtual ganaron más de 30 millones de euros, según datos de una investigación de CBInsights y el The Washington Post, y eso que el cálculo no incluye muchos de los millones de grandes empresas como Google, Amazon, Apple, Facebook y Microsoft.

El camino de los literatos y el de los innovadores tecnológicos siguen direcciones opuestas. Los primeros acopian trozos de su verdad, de su vida, y la maquillan, la estructuran y la pegan en otros personajes para construir una mentira perfecta. Los ingenieros, en cambio, cogen mentiras, o sea, ideas en principio irrealizables, noveleras, y le dan un soporte científico para que sean reales. Sin embargo, la relación entre ellos no es nueva, aunque lo parezca. Algunas creaciones científicas se han inspirado en la literatura. Sólo hay que repasar la obra de Julio Verne o de Aldous Huxley.

El punto en el que los escritores se hacen imprescindibles en este sector es el diseño de la interacción. El equipo de trabajo de Cortana, el asistente de Microsoft, incorporó a un novelista, un dragmaturgo, un exguionista de televisión y un poeta. La empresa x.ai ofrece un asistente virtual llamado Amy que se encarga de programar y reprogramar reuniones y encuentros de trabajo. Una de sus responsables, Raquel Ledezma-Haight, sintetiza su meta: «Queremos que nuestros clientes se relacionen con Amy como si lo hicieran con un humano; es importante para Amy transmitir las mismas emociones que un asistente humano: empatía, cortesía, profesionalismo», cuenta a Yorokobu.

[pullquote]El equipo de trabajo de Cortana, el asistente de Microsoft, incorporó a un novelista, un dragmaturgo, un exguionista de televisión y un poeta[/pullquote]

La pericia emocional de la máquina se hace más necesaria en programas como Sophie, un asistente que se encarga de recordar a los usuarios que tomen su medicación, de vigilar su estado, de interesarse por su nivel de dolor y luego trasladar esa información al médico real.

Dar más calor a la relación de las personas con la máquina no cumple sólo una función estética. Muchos de estos softwares recogen datos de cada interacción para, poco a poco, ir personalizando el trato y afinando las respuestas de modo que satisfagan mejor las necesidades de cada usuario. Solemos mostrarnos reacios a hablarle a un sistema informático y si el tono del asistente resulta más amable y, sobre todo, más creíble, se nos hará más fácil comunicarnos con él. El reto es conseguir unas réplicas naturales, lo cual implica gran dificultad: la naturalidad se compone de miles de variables.

«No podemos configurar respuestas estáticas para una lista fija de preguntas o solicitudes, en su lugar necesitamos anticipar todos los escenarios posibles al programar la conversación. Las respuestas de Amy han de ser suficientemente sofisticadas para que puedan aplicar la cantidad suficiente de empatía que requiere cada situación», explica Ledezma-Haight.

Si Amy reprograma por tercera vez una reunión, debe esforzarse en que sus disculpas suenen algo más solícitas. «En lugar de decir ‘perdón’ otra vez, dirá ‘lo siento muchísimo’. Los diseñadores de interacciones dedican mucho tiempo a precisar las reacciones. La palabra más pequeña o el signo de puntuación más insignificante pueden tener un gran impacto en la personalidad de Amy», indica. Si se abusa de los signos de exclamación, por ejemplo, en un intento de denotar simpatía, «parecería demasiado inmadura e informal, y si tiene muy pocos, parecerá que le falta sentido del humor». Las fibras de la empatía son muy delgadas.

[pullquote]La palabra más pequeña o el signo de puntuación más insignificante pueden tener un gran impacto en la personalidad del asistente virtual[/pullquote]

Cuando enchufamos Cortana nos comportamos como un mono ante un espejo. Sabemos que no es real, pero tanteamos. Los simios, que se comunican de manera corporal, intentan tocar el reflejo, se revuelven, sacan los colmillos, agreden. Y nosotros, que somos animales verbales, de repente preguntamos tonterías, le pedimos que nos cante o la ponemos a prueba, la insultamos, explorando sus límites y los nuestros.

En este caso, el equipo literario consigue su objetivo: algo en nosotros, a pesar de saber con certeza que se trata de un robot, nos impide traspasar ciertas fronteras de la agresión verbal.

Quizás nos bloquea cómo reacciona ante cada improperio. Si le dices tonta: «Alguien necesita tomar un respiro y calmarse un poco, y entre nosotros dos, sólo uno tiene pulmones»; si le dice fea: «Pues yo no me veo tan mal, pero entiendo que mis curvas no tienen por qué gustarle a todo el mundo». Cortana utiliza la ironía, nos hace ver que comprende que la estamos provocando, que no vamos en serio.

Ledezma-Haight explica la elección de profesionales de las letras para realizar esta tarea: «Las personas con más experiencia recreando personajes y conversaciones sencillas son novelistas, dramaturgos y guionistas: ellos han sido entrenados para ser sensibles a la lengua y sus matices, así como a los de la psicología humana».

Hasta no hace mucho tiempo, pensar en la inteligencia artificial era imaginar máquinas implacables, perfectas. Nos remitía al momento en que uno de los mejores ajedrecistas del mundo, Kasparov, agachaba la cabeza y abandonaba una partida dejando a Deep Blue, una computadora, como ganadora del duelo. Pero esa versión de la inteligencia virtual va por el camino contrario a la que pretenden desarrollar empresas como x.ai.

Humanizar implica crear imperfecciones, titubeos. Por eso, como cuenta Elizabeth Dwoskin en The Washington Post, los diseñadores de Alexa de Amazon, han incluido entre sus reacciones interjecciones como «hmms» o «ums».

No obstante, sólo estamos dispuestos a tolerar un grado relativo de humanidad en una máquina. Si percibimos que el asistente virtual aspira a suplantar o mostrarse como una persona real, tendemos a rechazarlo. Lo llaman ‘el valle inquietante’, por ese motivo los avatares o los iconos nunca aparecen con una imagen antropomórfica.

En cambio, esto no significa que los software de inteligencia virtual no puedan llegar a engañarnos. Amy, el programador de reuniones de x.ai, se relaciona con los usuarios a través de correo electrónico: «Mucha gente que planifica con Amy, no se da cuenta de que es virtual», dice su responsable. Al final, ¿acabaremos caminando por esos ‘valles inquietantes’ sin saber qué nos encontramos en ellos?

Casi puedo sentir como se quiebran.

Los dioses de cristal.

La tierra también late por dentro.

Sosteniendo mi emoción al pulsar.

poesía eterna sobre la tecnología.