Que las cosas no son lo que son sino lo que parecen es una máxima que vale para casi todo, desde una campaña de marketing a ligar en una discoteca. Esa idea de apariencia, sin embargo, no va solo por lo superficial, sino también por las expectativas de cada cual: según lo que percibimos o creemos, interpretamos la realidad de una forma u otra, aunque estemos equivocándonos.

Algo así es lo que debieron pensar, por ejemplo, en el aeropuerto de Houston hace unos años, cuando se enfrentaron a una avalancha de quejas de sus viajeros por lo mucho que tenían que esperar en el punto de recogida del equipaje.

Según cuenta un artículo The New York Times, las autoridades lograron reducir ese lapso de tiempo, pero las quejas seguían en aumento. La solución: hacer caminar a los viajeros por la terminal un rato hasta que las maletas casi estuvieran listas para reducir así la sensación de espera. Se trataba solo de mantener a la gente activa, aunque fuera haciendo algo inútil, en lugar de tenerla esperando.

Se podría decir, por tanto, que también hay un diseño de la apariencia. No es solo hacer las cosas más apetecibles, transmitir una idea concreta con un color o cautivar al usuario con un envoltorio efectivo para un producto mediocre. Se trataría de aprovechar una particularidad humana para deformar la realidad como medio para un fin. Existe, pues, un filón en esa distorsión: una cosa es lo que sentimos, creemos o percibimos, y otra muy distinta la realidad.

Hoy en día hasta la forma en que se hacen los productos digitales bebe de esa idea. Los expertos en experiencia de usuario, que vendrían a ser el arquetipo de prestidigitadores de sensaciones, se han dado cuenta del error de concepto que había detrás de varios estándares a los que estamos acostumbrados. Así, por ejemplo, la típica barra de progresión o la rueda dando vueltas cuando algo está cargando solo sirven para centrar la atención del usuario en el hecho de que está esperando. Y eso aumenta –y mucho– su impaciencia.

La solución que proponen, de nuevo, es un engaño. Se trata de las llamadas estructuras esqueleto, que se pueden ver en algunas apps y páginas de uso común como LinkedIn o Netflix: mientras ejecuta lo que has solicitado, te enseñan una página con la estructura vacía, de forma que el usuario percibe que la carga está siendo rápida aunque sea exactamente igual de lenta.

La idea, en general, no es nueva. Ni mucho menos. Piensa en Platón y su caverna –aquello de que solo vemos sombras– y estira el planteamiento hasta Matrix –la realidad no existe, es solo una herramienta–. De hecho, el cuestionamiento de lo real y lo percibido es bastante común en la ficción. Pero también en la realidad.

Hasta en los medios de comunicación se habla de realidad mediatizada, que es aquella que los lectores perciben como real y, en oposición, la que ignoran si no es cubierta y explicada por los medios. Dicho de forma más corta: lo que no se publica no existe. ¿Te acuerdas de Joseph Kony, aquel del vídeo que se volvió viral en 2012? Sigue ahí, aunque ya nadie le preste atención.

Percepciones y expectativas en política

Más allá del diseño, la filosofía o la comunicación hay dos áreas en las que esta disociación entre realidad y apariencia se ha usado con frecuencia. Una es la ya mencionada publicidad y la otra, la política, donde las expectativas también modulan y matizan la realidad.

Sucede cuando hay un contexto de malestar, momento en el que la idea de cambio es el arma más poderosa para ganar unas elecciones, tal y como le pasó al PP de la mayoría absoluta tras el estallido de la crisis.

El ejemplo más extremo en ese sentido se da cuando el malestar va contra el propio sistema: Donald Trump ganó porque Hillary Clinton encarnaba el establishment –una saga política familiar cuya victoria era aparentemente inevitable–. Exactamente lo mismo ha sucedido con Vox en Andalucía: allí el establishment era el PSOE y no había opción más contraria a un régimen que nunca había perdido el poder que la que proponían ellos.

La política patria, enloquecida y acelerada desde hace cinco años, es un buen caso de estudio para esa disociación de la realidad mediante percepciones. Así, por ejemplo, Podemos vivió como un fracaso el ser la tercera fuerza del país a primeras de cambio siendo como era algo histórico. O Ciudadanos, que emergió porque supo crear la percepción de ser un partido nuevo y dinámico en oposición a UPyD, cuando en realidad la formación de Rosa Díez era bastante más reciente.

Sucede también que, cuando la gente considera que un partido gestiona mejor, tiende a imponer esa idea incluso cuando en la realidad hay un flagrante estallido de corrupción, como sucedió en Cataluña con CiU, en la Comunidad Valenciana y Madrid con el PP o en Andalucía con el PSOE.

En esa construcción de lo que la gente percibe y cree que sucede intervienen de forma directa muchos actores. Los medios de comunicación han sido quizá el más relevante de todos ellos durante décadas –y quizá siguen siéndolo al inicio del proceso–, pero son ahora las redes sociales las plataformas en las que la amplificación tiene lugar.

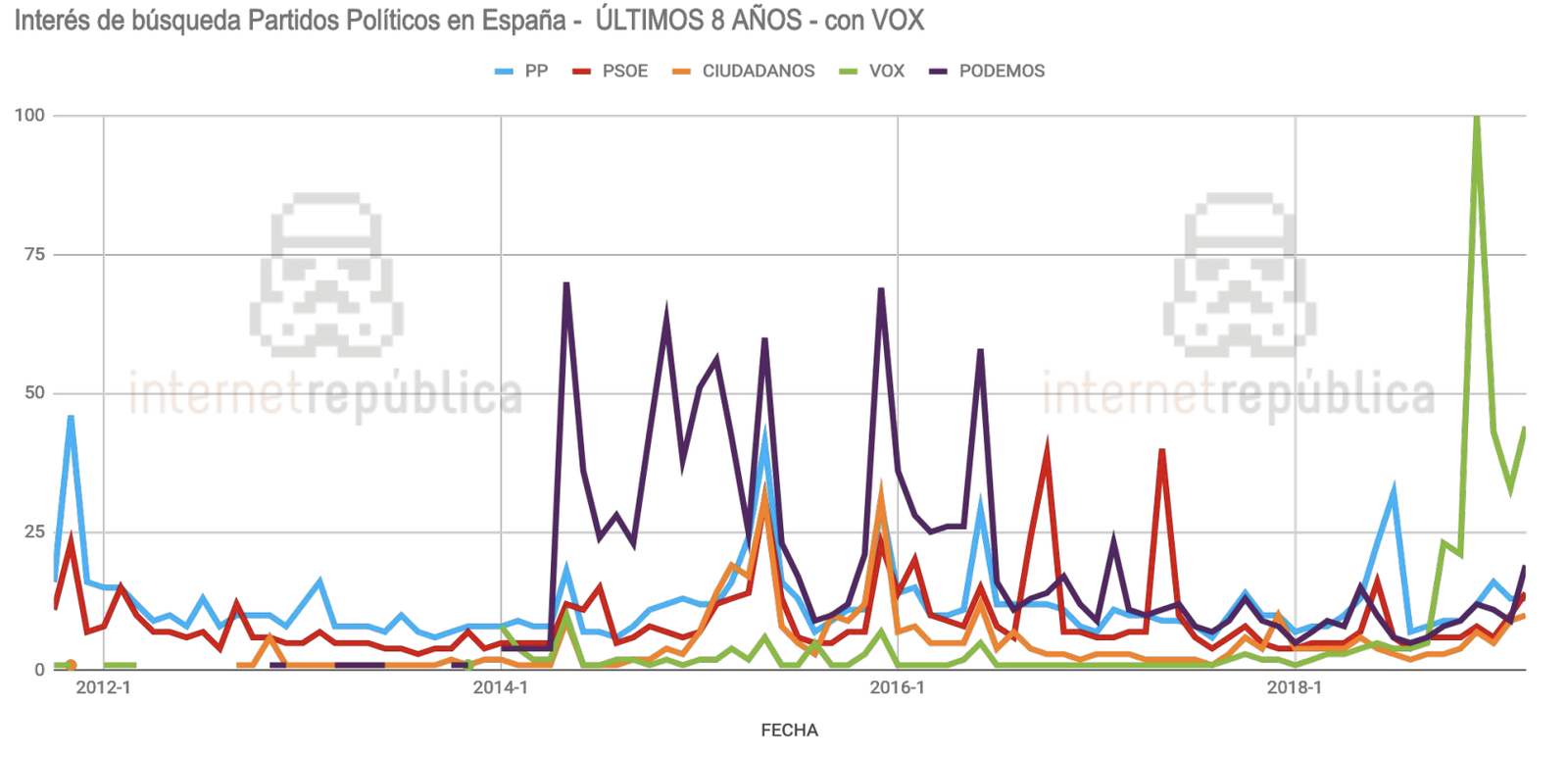

Este estudio de Internet República acerca de la presencia de los distintos partidos en internet muestra una clave interesante. Las formaciones emergentes irrumpieron tras ciertos hitos contados a través de los medios, pero su efecto se extiende y magnifica por el eco en la Red. Así, Podemos irrumpió tras las elecciones europeas de 2014; Ciudadanos, tras su exitosa operación de expansión nacional bautizada como Movimiento Ciudadano; y Vox lo hizo tras su inesperado llenazo en Vistalegre.

Tecnología para agudizar aún más la brecha

Aunque nada de esto sea nuevo, sí ha habido un cambio: la tecnología ha agudizado la disociación. Podría decirse que hay una chispa necesaria antes de que prenda la mecha, que quizá sean los medios de comunicación u otros actores. El problema es que una vez que empieza el fuego es muy complicado detenerlo.

De eso van teorías más recientes, como la de la burbuja de opinión o la cámara de eco. A grandes rasgos la idea se centra en que tendemos a seguir a gente que piensa más o menos como nosotros, de forma que creemos que todo el mundo ve las cosas de esa manera. De nuevo es algo que ha sucedido siempre –familia, compañeros de estudios o trabajo, gente afín–, pero que en las redes sociales se multiplica hasta el absurdo, en gran parte porque favorece la creación de comunidades de interés.

En esta línea reflexionaba un artículo de El País acerca del terraplanismo: por descabellado que sea creer que la Tierra es plana en pleno año 2019, lo más preocupante es que resulta imposible convencerles de lo contrario.

Como sucedía con las creencias atávicas, que buscaban una explicación sobrenatural a un fenómeno todavía incomprensible, las teorías de la conspiración han encontrado en la Red su acomodo perfecto: hay hordas de gente que necesitan explicaciones tranquilizadoras a fenómenos variados y encuentran argumentos que refuerzan sus visiones invirtiendo la carga de la prueba contra lo empírico.

Pero la ayuda tecnológica no es solamente socializadora. Un experimento de hace un par de años con un motor de inteligencia artificial arrojó un resultado aterrador: el sistema aprendió en unas horas que lo correcto en un entorno de redes sociales era acabar siendo racista y homófobo. Los algoritmos que hemos considerado desarrollar aprenden de nuestros usos y hábitos, devolviéndonos exactamente lo más común –entendiéndolo como satisfactorio–.

En un nivel más local eso se aplica a lo que buscamos, por ejemplo: Google apenas mapea un pequeño porcentaje de lo que hay en internet, y lo hace jerarquizando resultados a través de criterios variados, entre ellos cuántas veces la gente ha clicado en lo que ofrecen –entendiéndolo como un resultado favorable–. Es un bucle infinito del que apenas algunos salen, y como mucho lo hacen indagando en dos o tres páginas más de resultados, que no dejan de ser entornos perfectamente controlados.

El ejemplo más reciente vino de la mano de la comprobación que hizo un youtuber sobre la forma en que pedófilos habían hackeado el motor de recomendaciones de Google. Según explicó, colocaban comentarios con enlaces a momentos exactos de vídeos donde se podía ver algún descuido de los niños en la cámara en forma de desnudez. Lo peor venía después: si veías el vídeo y seguías alguno de esos enlaces, YouTube empezaba a recomendarte otros vídeos concretos con momentos similares para que los vieras porque entendía que era lo que querías ver.

Es evidente que la inteligencia artificial –en una escala amplia– o los algoritmos creados para que encuentres resultados satisfactorios y similares no tienen como objetivo nada de esto. Spotify lo usa para que encuentres música que te puede gustar, y YouTube lo aplica a que encuentres canciones, aunque no sepas su nombre. Sin embargo, el uso cerrado y predecible que hacemos los humanos de esa disociación entre realidad y percepción acaba moldeando a su imagen no solo opiniones y usos, sino también herramientas tecnológicas.

https://twitter.com/davidpareja/status/1105504364091920384